еңЁwindowsдёҠйҖҡиҝҮpytorch-directmlеҲ©з”ЁAMDжҳҫеҚЎеҠ йҖҹstable-diffusion

automatic1111зҡ„webuiеңЁwindowsдёӢеҸӘж”ҜжҢҒиӢұдјҹиҫҫзҡ„жҳҫеҚЎ

еҸҲдёҚжғіиЈ…linuxеҸҢзі»з»ҹпјҢеҸӘиғҪеӢүејәз”ЁCPUеҮ‘еҗҲдёҖдёӢпјҢйҖҹеәҰйқһеёёж…ўпјҢдёҖж¬Ўиҝӯд»ЈеёёеёёйңҖиҰҒ90з§’пјҢеӨҡзҡ„з”ҡиҮіи¶…иҝҮдёӨеҲҶй’ҹпјҢжңҖеӨҡиғҪжңү150~200з§’гҖӮжҲ‘еҺ»зҪ‘дёҠжүҫпјҢеҸ‘зҺ°дёӨз§ҚзҗҶи®әдёҠеҸҜиЎҢзҡ„ж–№жі•пјҡ

第дёҖз§ҚжҳҜдҪҝз”Ёort-nightly-directmlпјҢе…·дҪ“еҸҜеҸӮиҖғиҝҷзҜҮж•ҷзЁӢгҖӮ

第дәҢз§Қе°ұжҳҜpytorch-directmlгҖӮдҪҶжҳҜпјҢжҲ‘з”өи„‘зҡ„жҳҫеҚЎеҸӘжңү2GBдё“з”ЁGPUеҶ…еӯҳпјҢOnnxStableDiffusionPipelineиҝһ512512зҡ„еӣҫйғҪз”ҹжҲҗдёҚдәҶпјҢжҸҗзӨәGPUеҶ…еӯҳдёҚи¶ігҖӮ256256зҡ„еӣҫзҡ„зЎ®еҸҜд»Ҙз”ҹжҲҗпјҢдҪҶиҫ“еҮәзҡ„е…ЁжҳҜзҷҪиүІгҖӮ

еңЁ2022е№ҙ12жңҲпјҢеҫ®иҪҜз»ҲдәҺеҸ‘еёғдәҶ1.13зүҲжң¬пјҢиҮіе°‘еңЁзҗҶи®әдёҠеҸҜд»ҘдёҺwebuiе…је®№гҖӮдҪҶжҳҜпјҢз»ҸиҝҮдәҶеӨҡж¬Ўи°ғиҜ•д№ӢеҗҺпјҢеҸ‘зҺ°жңүдёҖдёӘиҝҗз®—з¬ҰжІЎжңүеңЁpytorch-directmlдёӯе®һзҺ°пјҲissue:pytorch-directml not working with Stable DiffusionпјүгҖӮ

еҸҲеҲ°дәҶ2023е№ҙпјҢеҫ®иҪҜеҸ‘еёғдәҶжңҖж–°зүҲжң¬пјҢе…¶дёӯж”ҜжҢҒдәҶиҜҘиҝҗз®—з¬ҰгҖӮз”ұдәҺtorch-directmlзҡ„дёҖдёӘbugпјҲissue:torch-directml : RuntimeError on torch.cumsum with bool inputпјүпјҢеңЁиҝҗиЎҢwebuiж—¶пјҢдјҡеҮәзҺ°иҝҗиЎҢй”ҷиҜҜгҖӮдҪҶиҝҷдёӘй”ҷиҜҜзӣёеҜ№еҘҪж”№пјҢеҸӘиҰҒеңЁwebuiдёӯжҠҠдёҖдёӘboolеҗ‘йҮҸиҪ¬жҚўжҲҗintзұ»еһӢзҡ„е°ұеҸҜд»ҘгҖӮ然еҗҺпјҢеҸӘиҰҒи®°еҫ—еңЁиҝҗиЎҢеҸӮж•°дёӯеҠ дёҠ --lowvram --skip-torch-cuda-test --precision full --no-half еҚіеҸҜжӯЈеёёиҝҗиЎҢгҖӮ

дҪҶжҳҜпјҢиҝҳжҳҜжңҖеӨ§еҸӘиғҪз”ҹжҲҗ384*384еӨ§е°Ҹзҡ„еӣҫзүҮпјҢеӣ дёәиҷҪ然еңЁж–Үжң¬зј–з ҒеҷЁе’ҢеӣҫеғҸдҝЎжҒҜеҲӣе»әеҷЁйҳ¶ж®өжІЎжңүеҮәзҺ°й—®йўҳпјҢдҪҶз”ұдәҺGPUеҶ…еӯҳдёҚеӨҹпјҢеңЁеӣҫеғҸи§Јз ҒеҷЁзҺҜиҠӮеҸҲжҠҘй”ҷгҖӮ

жҹҘжүҫиө„ж–ҷеҗҺпјҢеҸ‘зҺ°жҳҜеӣ дёәеңЁд»Јз ҒйҮҢпјҢеӣҫеғҸи§Јз Ғзҡ„第дёҖдёӘжӯҘйӘӨжҳҜеңЁGPUдёӯиҝӣиЎҢзҡ„пјҢжүҖд»Ҙз”Ёе®ҢдәҶеҶ…еӯҳгҖӮжҲ‘жҠҠиҝҷдёӘжӯҘйӘӨиҪ¬з§»еҲ°дәҶCPUдёӯиҝӣиЎҢпјҢе°ұж¶ҲйҷӨдәҶеҶ…еӯҳжҠҘй”ҷпјҢжҲҗеҠҹз”ҹжҲҗеӨ§е°Ҹиҫҫ768*768з”ҡиҮіжӣҙеӨ§зҡ„еӣҫгҖӮдёҖеј еӣҫеҝ«зҡ„дёҖиҪ®иҝӯд»ЈйңҖиҰҒеҚҠеҲҶй’ҹпјҢеӨҡзҡ„йңҖиҰҒ60з§’пјҢ768еӨ§е°Ҹзҡ„д№ҹе°ұдёғе…«еҚҒз§’гҖӮ

пјҲжіЁпјҡеҺҹж–ҮдёӯжӯӨеӨ„й—®йўҳе·Іи§ЈеҶіпјү

ж–№жі•дёҺз»ҶиҠӮ

йҰ–е…ҲжүӢеҠЁеҲӣе»әиҷҡжӢҹзҺҜеўғ并е®үиЈ…torch-directmlпјҡ

python -m venv venv

.\venv\scripts\activate

pip install torch-directml

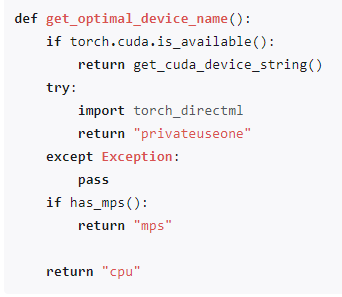

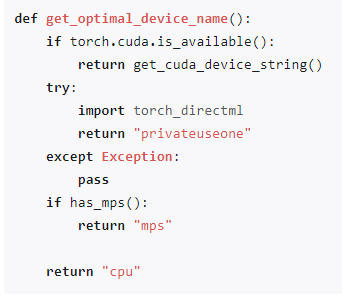

еҶҚе°Ҷstable-diffusion-webui/modules/devices.pyдёӯзҡ„get_optimal_device_nameеҮҪж•°ж”№жҲҗиҝҷж ·пјҡ

def get_optimal_device_name():

if torch.cuda.is_available():

return get_cuda_device_string()

try:

import torch_directml

return "privateuseone"

except Exception:

pass

if has_mps():

return "mps"

return "cpu"

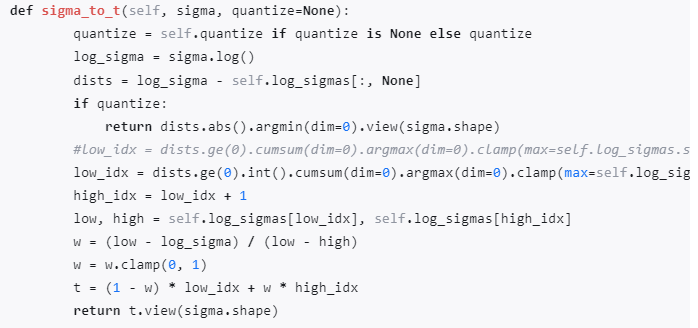

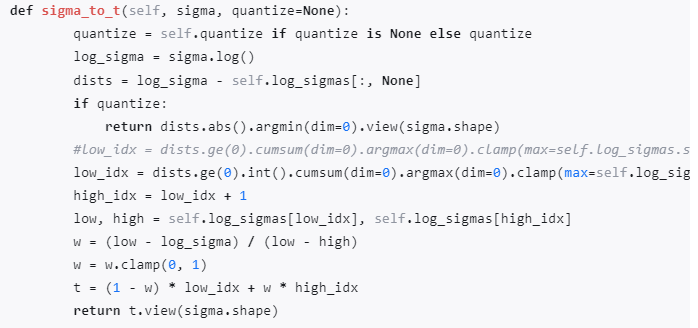

然еҗҺдҝ®ж”№stable-diffusion-webui\repositories\k-diffusion\k_diffusion\external.pyдёӯзҡ„sigma_to_t еҮҪж•°пјҡ

def sigma_to_t(self, sigma, quantize=None):

quantize = self.quantize if quantize is None else quantize

log_sigma = sigma.log()

dists = log_sigma - self.log_sigmas[:, None]

if quantize:

return dists.abs().argmin(dim=0).view(sigma.shape)

#low_idx = dists.ge(0).cumsum(dim=0).argmax(dim=0).clamp(max=self.log_sigmas.shape[0] - 2)

low_idx = dists.ge(0).int().cumsum(dim=0).argmax(dim=0).clamp(max=self.log_sigmas.shape[0] - 2)

high_idx = low_idx + 1

low, high = self.log_sigmas[low_idx], self.log_sigmas[high_idx]

w = (low - log_sigma) / (low - high)

w = w.clamp(0, 1)

t = (1 - w) * low_idx + w * high_idx

return t.view(sigma.shape)

ж–ҮдёӯжңҖеҗҺжүҖжҸҗеҲ°зҡ„дјҳеҢ–еҰӮдёӢпјҡпјҲstable-diffusion-webui/modules/processing.pyпјү

samples_ddim = samples_ddim.to(devices.dtype_vae).to("cpu")

x_samples_ddim = decode_first_stage(p.sd_model, samples_ddim)д»ҘеҸҠstable-diffusion-webui/modules/lowvram.pyдёӯпјҡ

def first_stage_model_decode_wrap(z):

#send_me_to_gpu(first_stage_model, None)

return first_stage_model_decode(z)